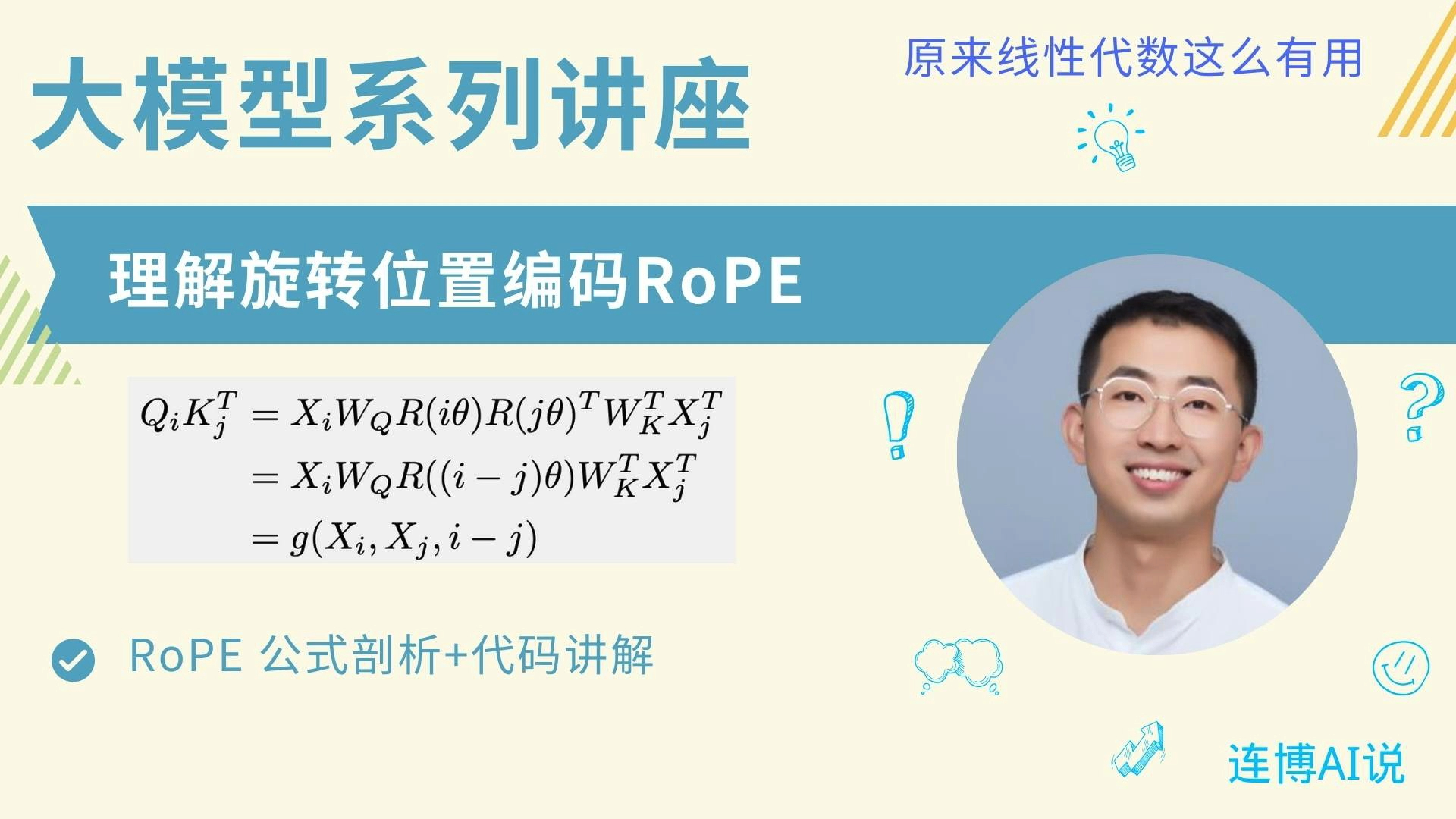

解密旋转位置编码:数学基础、代码实现与绝对编码一体化探索

xxll88:

xxll88:

UP主真正地把线性代数在AI中的作用讲了出来,其他人的课程从原理讲到代码,线代感觉只是个表示层而已,不愧是数学博士,有了第一讲的基础(看了3遍),能基本看懂第二讲,理清了以前对ROPE的模糊概念,有点不太明白:行向量和正交的子空间之间的关系,为什么正交的子空间旋转后合并后还是原行向量。

【回复】谢谢支持,很高兴视频能帮助到你。关于你的问题,首先,行向量和正交子空间没有啥关系,行向量和列向量不过是我们微观上去理解矩阵意义的方式,有的论文用行向量,有的用列向量,没有啥区别,掌握一种理解方式就行。正交的子空间这个是数学上常常说的一个概念,我们平常的欧式空间任意的拆分都是正交的子空间,(如果不好理解,可以放弃这个概念,也不影响你对rope的理解)。关键的地方是几个二维的旋转矩阵沿着对角线堆叠起来的物理意义,是在这些子空间上做独立的旋转。也不用太纠结正交这个概念。

【回复】回复 @连博AI说 : 最开心就是听到老师说哪里不用学,下次准备讲什么 ,不催更 李总同学Plus:

李总同学Plus:

出一期讲manba的视频,看到底会不会取代Transformer 27317913707_bili:

27317913707_bili:

老师请问我理解的u是embedding维度上偶数位的向量集结,v是奇数位的,为什么您u是取前d维度的,v是取后d维度的?

【回复】首先感谢你的仔细观看。你可以这样思考,如果我能把对应的cosine,sine乘到对应的位置就行了,心里知道哪两个坐标对应我的一个二维子空间就行了,至于说这个二维子空间的坐标是一起还是打散的都不重要了。

【回复】回复 @27317913707_bili :没事

【回复】回复 @连博AI说 :明白了,谢谢老师 call-me-jokerman:

call-me-jokerman:

虽然只出了两个视频,但质量都很高[脱单doge] 华京院:

华京院:

良作无人,我现在学tranformer也觉得并行是靠矩阵乘法,但是体会很碎片,看完up视频才有一种体系感,不愧是北大博士[打call] 湖心亭_叹江雪:

湖心亭_叹江雪:

这个旋转位置编码是苏神那篇论文里的吗[思考]

【回复】是的,参考论文里面有写 心如死灰ik:

心如死灰ik:

讲得真好,是真想让人听明白的,[给心心] 没有思考万物美好:

没有思考万物美好:

太牛了,用了很久的roPE这次终于听懂了哈哈哈哈 Lekayef桑:

Lekayef桑:

打扰,您好,在 解密旋转位置编码:数学基础、代码实现与绝对编码一体化探索 中:

7:08 到 7:27 您说的是DN 还是 DNN? 能解释一下为什么离散的输入它不好处理呢? 谢谢

【回复】回复 @连博AI说 : 连博您好,我基本理解了我提出的问题,非常感谢,但您的解释我有一部分没有理解,

1. 您说的数学上的各向同性是什么意思?指的是经过线性变换后的张量各向同性还是什么?

2. 归一化在DNN是主要用来抑制梯度爆炸或者消失并加速梯度下降(假设归一化的输入分布为高斯分布),您在数学上怎么解释归一化为DNN带来的好处令我十分好奇。

3. 您对归一化后优化空间的 “有点别扭” 是怎么别扭呢?

【回复】是DNN。我说下数学上的一些感觉啊,优化上我们比较喜欢各项同性的,等高线最好是圆形的区域上优化(这也是我们做input归一化的一些motivation),连续值的field和离散值的field放在一起,你的归一化后优化空间就有点别扭。另外是离散的东西往往背后是一些属性值,我们同时希望学习这些属性背后的关系,而不是一个个的one hot 整数值,比如一个个的离散的token,年龄,embedding 可以帮助你来学习这些属性值背后的连接关系。不过你让我想起来大规模离散逻辑回归的ctr时代,那个时候大部分都是01型的特征。进入DNN的时代后,基本都是连续型的了。 Lekayef桑:

Lekayef桑:

教授,请问transformer 类模型最大序列长度是怎么定义的?理论上模型参数只跟输入token维度相关。如果没有内存限制是不是能接受无限长度的token呢?

【回复】回复 @连博AI说 : 谢谢连博,非常详细!

【回复】另外就是,最大序列长度确实是受限于GPU的内存大小,如果没有内存限制,是可以接受的无限长度的token。