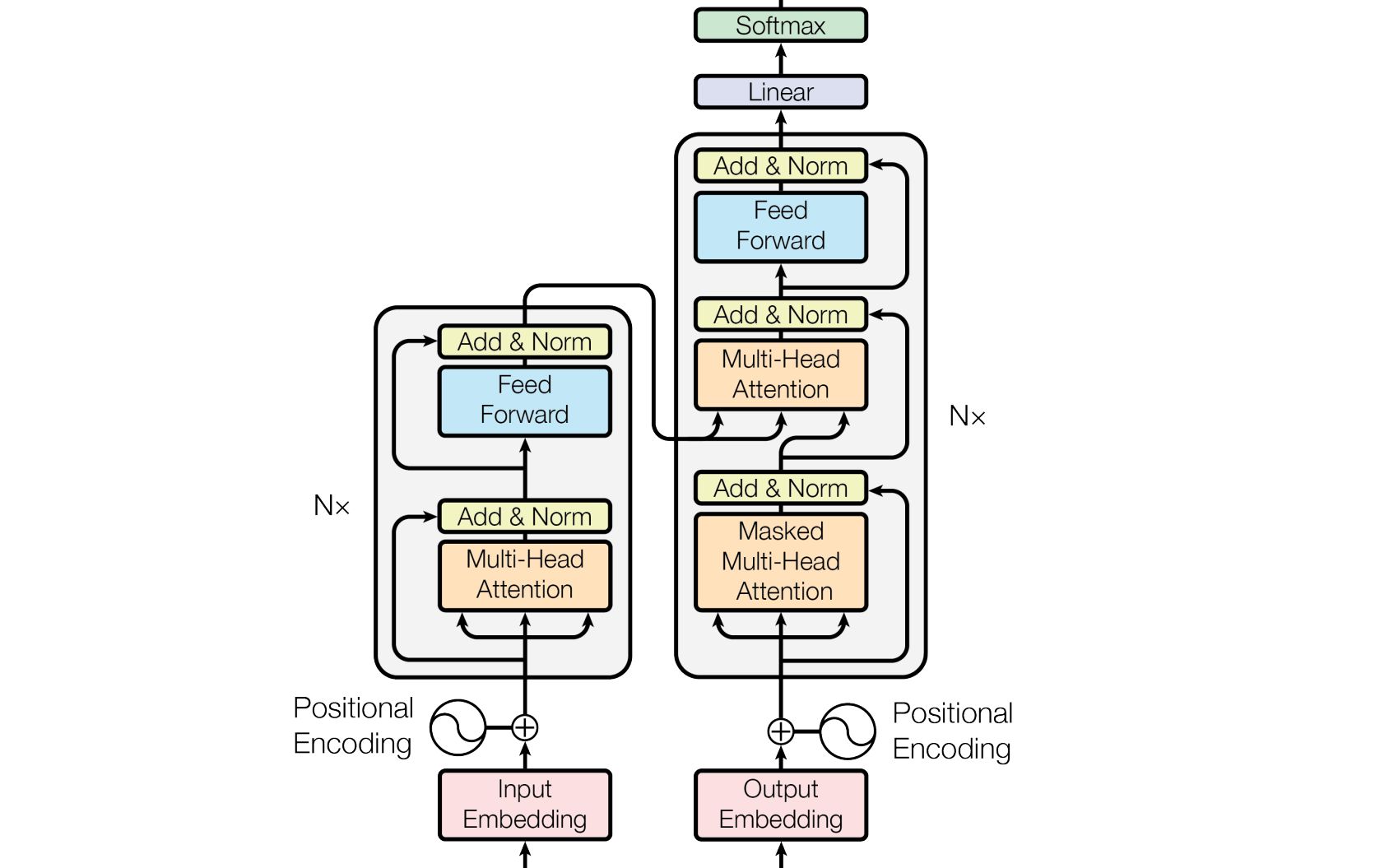

19、Transformer模型Encoder原理精讲及其PyTorch逐行实现

锦鲤小禺:

锦鲤小禺:

视频中的代码加详细注释我码出来了,不知道up主同不同意分享[doge]

【回复】私信全部都回复啦,收到分享请点赞,拒绝白嫖哦[脱单doge]

【回复】私信啦,求一份[脱单doge] 共胜文:

共胜文:

非常详细,目前是b站上最细致的transformer代码详解,质量高。 AIGC七哥:

AIGC七哥:

up太强了,跟着思路一点点把细节实现出来,非常有助于理解Transformer;

1:08:00处,按up这种写法:

src_pos = torch.cat([... torch.arange(max(src_len), 0) ...])

但是上边又有 max_position_len = 5

是不是应该把 max(src_len) 改成 max_position_len 呢?

【回复】我在观看视频时也产生了这个疑问,padding的内容也需要pe_embedding吧

【回复】回复 @bili_39628506979 :哦哦哦,这样啊,感谢,感谢。[捂脸]

【回复】回复 @沈皛XIAO :max_position_len是一个常数,而max不能针对常数用 deep_thoughts:

deep_thoughts:

本期主要详细讲解了Transformer的词向量、位置编码、编码器子注意力的掩码的原理,以及逐行对它们用pytorch进行实现。

【回复】回复 @水银小七 :都做mask会更严谨一点,当然也可以不用对query做mask,因为你说的loss也用到了mask。

【回复】回复 @deep_thoughts :好的,谢谢老师[呲牙]

【回复】回复 @梅菲斯特杳马 :怎么卡住了呢? 大猪蹄0906:

大猪蹄0906:

老师 有没有关于初始LSTM API的代码详解啊 怕秃头的Titus:

怕秃头的Titus:

大佬我哟一个疑问,通过遍历src_len生成位置索引那部分,为什么不考虑padding了,难道padding不需要位置编码吗?

【回复】你好,padding的地方也有位置编码的,这些编码会被attn mask给消除掉。

【回复】回复 @deep_thoughts : 就本节视频来说应该没有把padding位置编码吧?计算src_pos的时候传入的是max(src_len),padding位置是没有考虑进去的。(当然,就算有位置编码,也确实会被attn mask消掉) 万千星海Ephemeral:

万千星海Ephemeral:

请问Transformer的损失函数是什么呀[脸红]

【回复】你好,可以看我PyTorch教程的第21期视频 lipengpeng456:

lipengpeng456:

期待下次直播,想问问up下次直播啥时候?

【回复】刚刚已经直播结束了[调皮] 叫叔就OK:

叫叔就OK:

原理讲的很透,代码演示很细致,全网最佳! 菜花bb:

菜花bb:

老师,请问方便把本课的代码分享出来吗?