通俗易懂-大模型的关键技术之一:旋转位置编码rope (3)

jessieorzee:

jessieorzee:

太厉害了叭真的膜拜!!!!![打call] 阿婆来跳舞:

阿婆来跳舞:

旋转位置编码在qkv部分,会不会增加很多运算量

【回复】还好,用优化后的方法计算就还好 么得感情的仓鼠:

么得感情的仓鼠:

求API讲解,理论和源码一起将真是太好懂了[打call] Paradise59:

Paradise59:

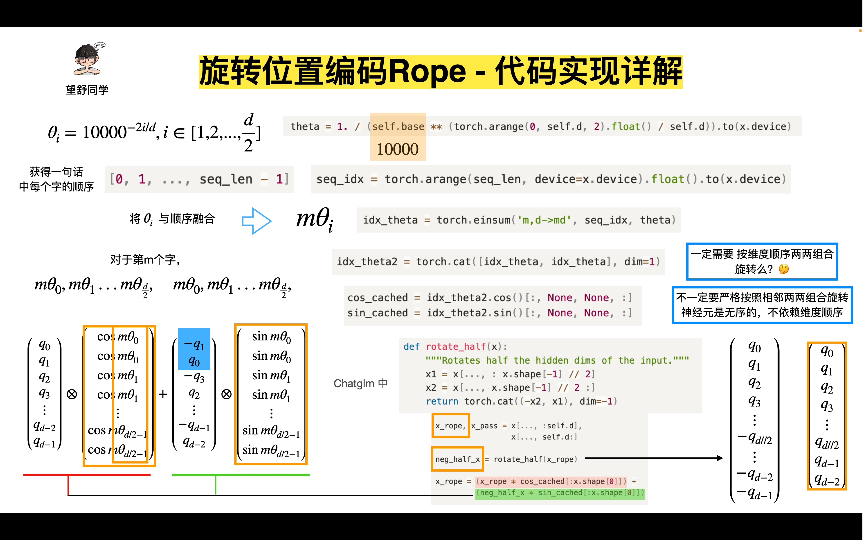

好像rotate_half那个图画错了,他把x2放在前面,x1放后面在 舅舅呃呃:

舅舅呃呃:

大佬,什么时候出时序图神经网络视频课呀 该用户末登录:

该用户末登录:

您好,可以请教一个问题吗?[给心心]

我使用Llama2的LlamaDynamicNTKScalingRotaryEmbedding,self.scaling_factor设置为8,任务不是NLP了,而是在ViT里面改动。现在我是将max_pos_embedding=257的预训练模型位置编码更换为RoPE,重新训练,但是并不能很好得外推到长度为1601的sequence(embedding长度)上。

这个问题很奇怪,因为以往ViT做dynamic sequence length的方法一般是inference时通过bilinear或者bicubic对pos embedding进行插值,我也尝试了,但也不能够很好得适配[委屈]

想问问您的见解[委屈] 该用户末登录:

该用户末登录:

您好,所以RoPE是给一个很大的vocabulary_size(视频中是10000)来初始化word embedding,同时初始化的theta,之后theta就是固定的数了,然后计算attention时的position embedding只取决于m-n这个相对位置。

那么在这里想问您一个问题,如果是转换到图像任务上,训练一般都是在imagenet上,sequence length一般是256+1,inference时保持patch size不变,sequence length会显著增加,这样训出来的模型在计算attention时会不会mismatch呀?[爱心]

【回复】同问,请问大佬知道了么 自卑狗子:

自卑狗子:

位置编码 用attention is all you need文章里的那个 效果如何