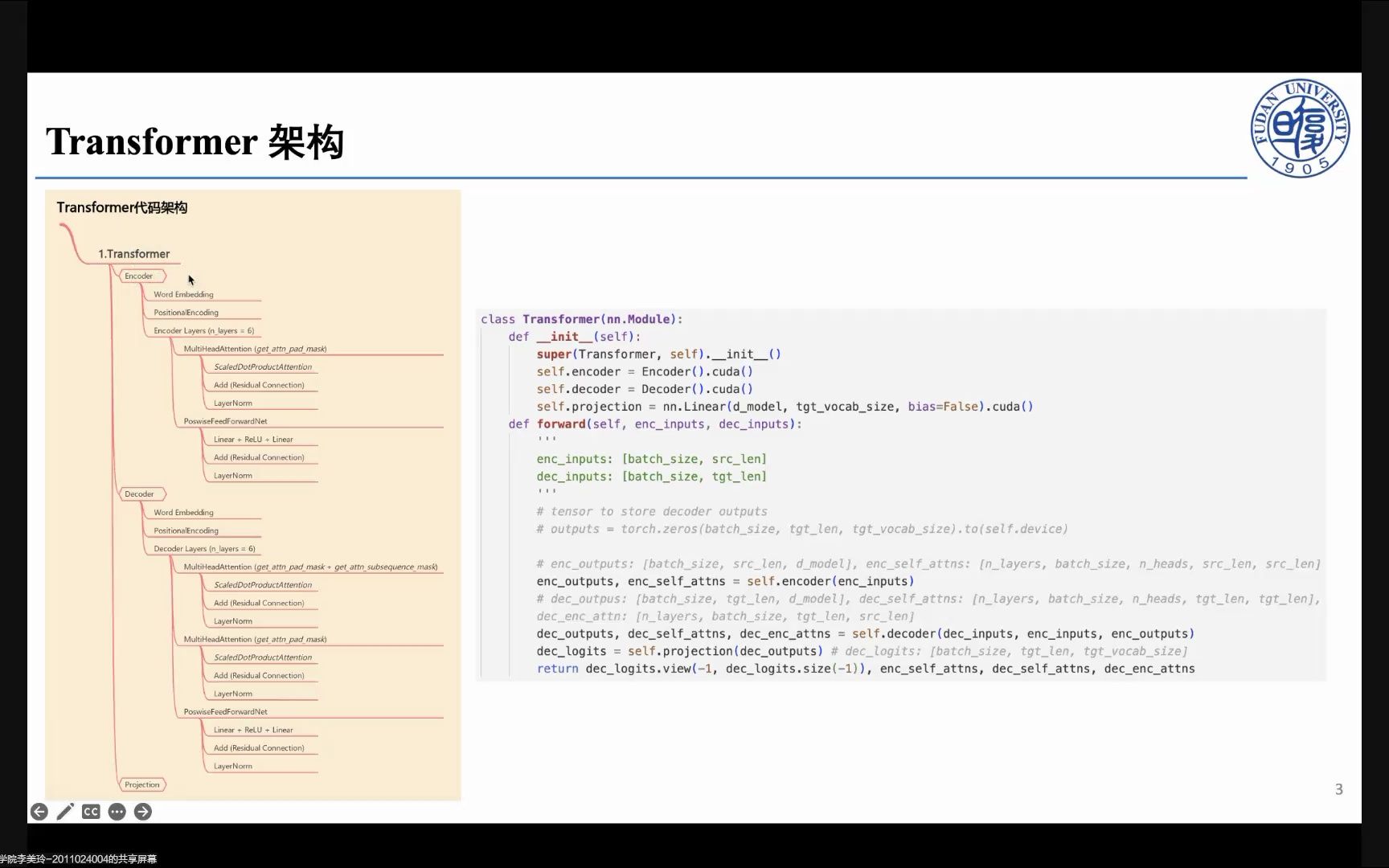

Transformer 的 Pytorch 代码实现讲解

stormyone:

stormyone:

讲的很好,清晰、冷静、有条理,不紧不慢,你适合做技术

【回复】回复 @fedfan_jst :做学术没有点技术支撑怎么做[doge]

【回复】回复 @国服第一海豹 : 感谢您![给心心][给心心] 虚怀盈风:

虚怀盈风:

讲得非常好!结合Transformer 原理进行源码讲解,思路清晰,讲完源码后马上趁热打铁分析了一个简单的实例,让人形成直观的认识,帮助非常大。

(美中不足的是PPT讲解部分,视频中所显示的鼠标位置与实际所指的位置并不同步,大概向上偏了5行,刚开始看的时候有点不太习惯)

【回复】回复 @奥利奥麦璇风 :vscode

【回复】回复 @_Meilinger_ :请问一下这个是在哪个软件运行啊[笑哭]

【回复】谢谢您的肯定!这个问题我也注意到了,是因为原始录屏界面上传时候缩放的关系,后续的视频中我会注意避免这个问题的! gaoshang1102:

gaoshang1102:

讲的很清楚!UP在做什么项目?招收线上实习生吗?

【回复】谢谢你的肯定!这个视频其实是我们实验室给新生培训用的,我把它分享到这里和大家一起学习~

【回复】回复 @_Meilinger_ :太好了,三连送上

【回复】回复 @_Meilinger_ : 多来点,求你啦 柠檬精萨摩:

柠檬精萨摩:

我之前看过trans的torch源码,在clone layers的时候那个deepcopy感觉有点问题。建议用layer类就好了,自己叠层数

【回复】好哇~这个建议可以采纳[打call] 目标彩虹海S:

目标彩虹海S:

鼠标的位置和讲的地方不对应,好难受[大哭] 小黄瓜要加油:

小黄瓜要加油:

请问小姐姐transformer适合用来做气象变量的时间和空间预测吗

【回复】找到答案了吗 我也是做气象的[打call]

【回复】这个本人没有涉猎过呢,你可以看一下基于 U-Transformer 的伏羲大模型,就是用来做气象预测的[给心心] 73799871500_bili:

73799871500_bili:

upup,想问一下视频里提到的有关维度变化的链接可否提供一下呀

【回复】https://wmathor.com/index.php/archives/1438/ 凌尘忆殇:

凌尘忆殇:

请问Encoder Layer层中有做残差连接吗?为什么和论文中的图不太一样呢?

【回复】回复 @_Meilinger_ :好滴,谢谢您

【回复】有的,是在调用 MultiHeadAttention 时进行的残差连接,代码实现与《Attention Is All You Need》论文中的 Figure 1 对应的哈~ 都可以的嗯:

都可以的嗯:

请问视频8分钟提到的关于维度讲解的链接是啥呀 小九斗:

小九斗:

你好!想请教一个问题,在测试模型的代码中,调用greedy_decoder函数之后的下一行代码,为什么又调用一遍model预测? 潜伏G:

潜伏G:

太厉害了!我大四,毕设也想做多模态方向 短毛猪大怪兽:

短毛猪大怪兽:

想请教一下,掩码掩盖的未来词,是源句子中的未来词,还是目标语句的未来词?

【回复】你好~掩盖的是目标语句的未来词,因为解码器的目的是预测目标语句。 叶湘伦_o:

叶湘伦_o:

学姐 能分享一下思维导图吗[脱单doge] 点赞投币啦 Smile__Smile:

Smile__Smile:

你好,我想请教一个问题可以吗?

就是在代码里面的例子的sentences是只有两句话的翻译,所以自己构造src_vocab和tgt_vocab比较容易,但是如果需要训练很多sentences的时候,要怎么定义src_vocab和tgt_vocab呢?

【回复】回复 @_Meilinger_ : 谢谢回答~麻烦可以举一个构建字典的方法吗?或者我可以搜什么关键词能搜到呢?谢谢啦

【回复】同样可以通过构建字典的形式来构建词表 纯爱牛牛怪:

纯爱牛牛怪:

可能是大佬太紧张,我感觉讲的并不是很清楚 虽然结果跑出来了 但还是好多函数具体实现出来的结果没讲清楚是啥 就还是云里雾里的 可能是自己太笨了[大哭]

【回复】确实,不是面向零基础的实际上 太能喵不是大熊猫:

太能喵不是大熊猫:

老师讲的太好了,三连必须的,期待您的更多课程[打call][打call][打call]