简单讲一下我训练AI玩王者的思路

天启raf:

天启raf:

好家伙,AI刚刚能自己打欢乐斗地主,这又能出来打王者了

【回复】这个ai太差了,当然我也理解毕竟是个人开发的不如团队觉悟牛逼,没实际用处。参考学习就可以了

另外说下大佬的斗零我感觉胜率也不行,看了大部分视频都是输多赢少基本上都是说豆子输光了。

斗零实际平均胜率只有55%

想赢豆最少也要80%胜率

【回复】欢乐斗地主,这玩意儿就算赌神来了豆子也能输的精光吧。 蹄垫Official:

蹄垫Official:

人工给ai实时判断操作,觉得犯病就给他扣分,秀了就给他加分。 AI视频小助理:

AI视频小助理:

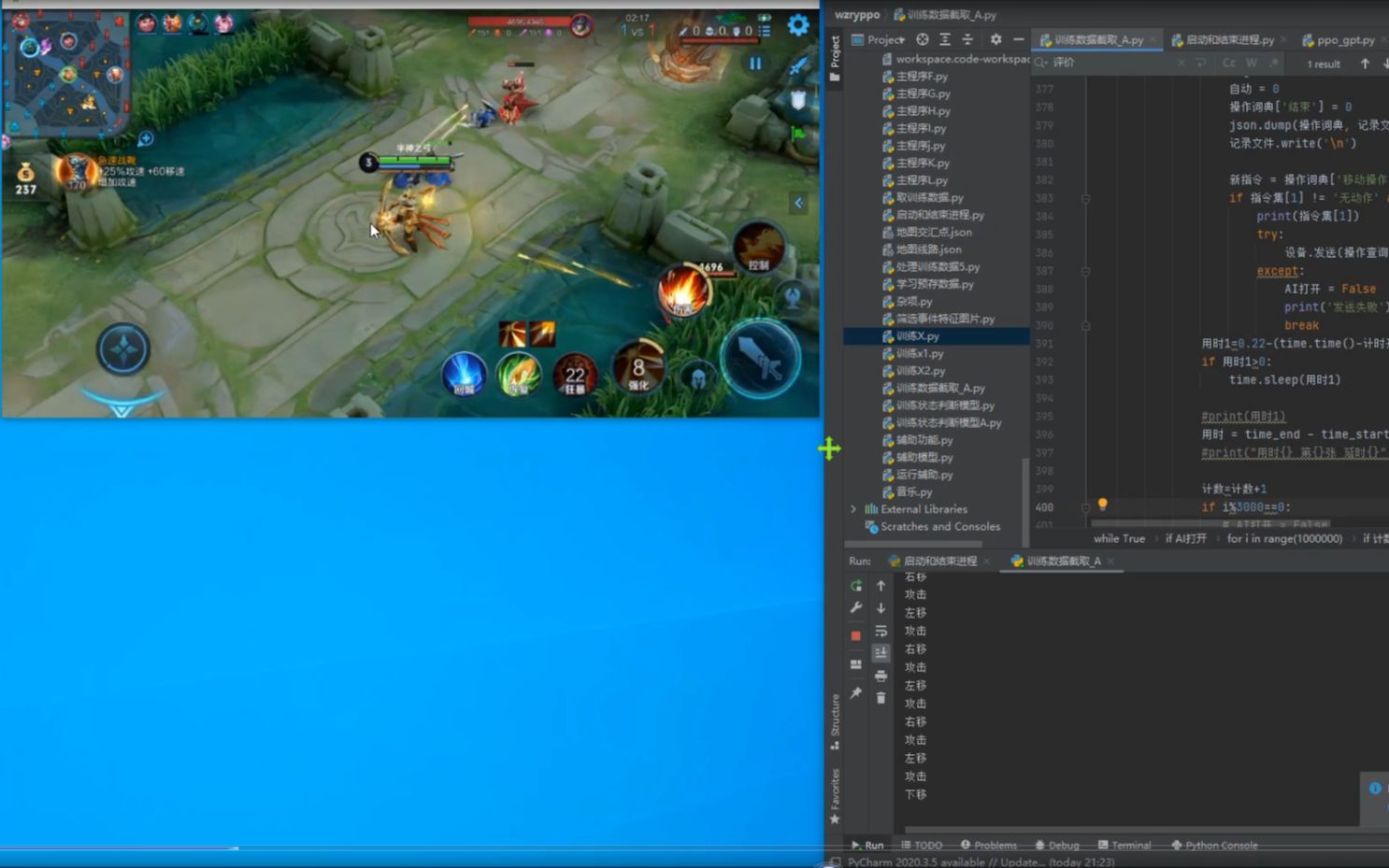

一、作者去年的AI玩《王者荣耀》的思路,使用了transformer进行推理和处理图片,通过图处理后的图片的向量代替磁向量,使用位置编码进行处理。

00:01 - 我讲一下我去年ai玩王者荣耀的思路

01:12 - 我用的思路是用transformer处理图片序列,经过卷积神经网络处理

03:02 - 我用图处理后的图片的向量代替磁向量,使用位置编码作为词向量

二、一种游戏的组合方法,通过将左下移发起进攻或下移三技能等操作组合在一起,形成一个词向量,从而实现游戏的控制。

04:07 - AI训练思路:组合左下移发起进攻或下移三技能等

04:56 - 只输入一次,网络进行推理,提高效率

08:04 - PP使用泛化优势函数,但存在训练效率问题

三、在训练AI时,必须使用手动数据来操控,否则训练将无法进行。同时,使用概率分布动作和回报模型来训练状态判断模型。

08:11 - 训练AI玩王者需要手动控制数据,不能让AI随机走

08:59 - 用手动数据训练AI会导致评价结果不准确,训练不出结果

11:26 - 训练AI的回报是通过判断状态的神经网络得出,特征明显

四、一个使用Transformer模型的AI游戏训练方法,以及该方法在游戏中的应用和缺陷。同时,还讨论了强化学习和监督学习的不同之处。

12:17 - 使用了Transformer模型,但参数不同,不需要判断回报。

13:19 - 训练模型需要44秒,手动操控最好在时间内击杀。

13:52 - 训练数据中存在好和坏的结果,需要考虑比例问题。

五、作者对于游戏中奖励设计的思考,以及使用神经网络进行训练的方法和注意事项。作者强调了经济的重要性,并提出了一些改进的空间。

16:20 - 梯度下降需要梯度上升,差一个负号的概念

17:07 - 奖励设计问题,高奖励鼓励击杀小兵,经济最重要

19:16 - 通过神经网络判断得到奖励,训练时要注意正反两方面经验对照

--本内容由AI视频小助理生成,关注解锁AI助理,由@pangpangdog 召唤发送 张江妲己:

张江妲己:

所以是需要人操作做训练的对吗,不然感觉训练效率感觉很低?

【回复】下载其它主播的录播,然后训练一个一样的模型[歪嘴]

等它挨锤的时候,用锤人现场作比对就知道操作是不是本人了[滑稽]

【回复】毕竟没有人家王者的源码,而且是图像识别。

【回复】回复 @K7815463CG :你真是鬼才 张江妲己:

张江妲己:

感觉很厉害,期待大佬以后多多分享[打call] 神之一手杀:

神之一手杀:

下载巅峰赛各大国服的录像。直接进行国服操作。 幽鸮:

幽鸮:

AttributeError: module 'torchtext.data' has no attribute 'Iterator'

这个咋办[笑哭] kayyyak:

kayyyak:

感觉有的像clip多模态呀 把图片弄进去transformer里面 从小可虎了:

从小可虎了:

把大佬的模型拿出来运行了一遍![打call]实际结果还是很惊喜的,是一套完整的理论! 强化学习练习生:

强化学习练习生:

使用中文来定义函数和变量看起来也是不错的。