头条面试:Kafka线上有大量消息积压,该如何处理(方法二)

念秋辞:

念秋辞:

一般来说,调优这些应该在上线前完成,性能瓶颈也应该压测出来,如果出现消息堆积,不如分析堆积的原因是什么?再根据具体业务情况决定用什么策略

【回复】说的很对,很有领导风范。 码上加薪:

码上加薪:

增加分区可能要估计到分区内消息的顺序性。一般出问题无论怎么做也来不及啊,肯定要发版本的

【回复】回复 @拼yin世界 :不容易做

【回复】这种也不容易做到不停机迁移吧? 大可学妹:

大可学妹:

以下是来自chatGPT的答案:

Kafka 线上大量消息积压可能是由于多种原因引起的,例如消费者处理能力不足、生产者发送速度过快、Kafka 集群配置不当等。针对不同的原因,可以采取不同的处理措施。

以下是一些可能的处理方法:

1.增加消费者数量:如果消息积压是由于消费者处理能力不足引起的,可以考虑增加消费者数量来分担负载。可以采用横向扩展的方式,增加消费者实例的数量,或者调整消费者的配置来提高消费能力。

2.调整消费者配置:如果消费者配置不当,也可能导致消息积压。可以考虑调整消费者的配置参数,例如批量消费消息的大小、消费者线程数量、最大重试次数等。

3.优化生产者发送速度:如果消息积压是由于生产者发送速度过快引起的,可以考虑优化生产者的发送速度,例如增加生产者实例的数量、调整生产者的配置参数等。

4.调整 Kafka 集群配置:如果消息积压是由于 Kafka 集群配置不当引起的,可以考虑调整 Kafka 集群的配置参数,例如增加 Kafka 集群的分区数量、扩容 Kafka 集群的节点数量、调整 Kafka 的存储策略等。

5.增加存储容量:如果消息积压是由于存储容量不足引起的,可以考虑增加存储容量,例如扩容 Kafka 集群的存储节点、使用更大容量的磁盘等。

综上所述,针对 Kafka 线上大量消息积压问题,需要根据具体情况采取不同的处理方法。如果不确定问题的根本原因,

【回复】回复 @wangliang2438 :等着他们退休我接班,我还是初级码农,还有很多时间

【回复】回复 @码上加薪 : 会,广州的外卖员都招满了

【回复】回复 @码上加薪 :哈哈哈哈,我现在有时候看面试题,不懂得已经下意识打开chatGPT了,然而这个东西才刚出现没多久,对我来说简直是颠覆性的搜索交互体验,太爽了[笑哭][笑哭][笑哭][笑哭] 深圳-Jax:

深圳-Jax:

加分区加消费者呢 这种是突然的流量过来 要求马上消费掉?

【回复】一般也做不到,只能后期整改 tanne222:

tanne222:

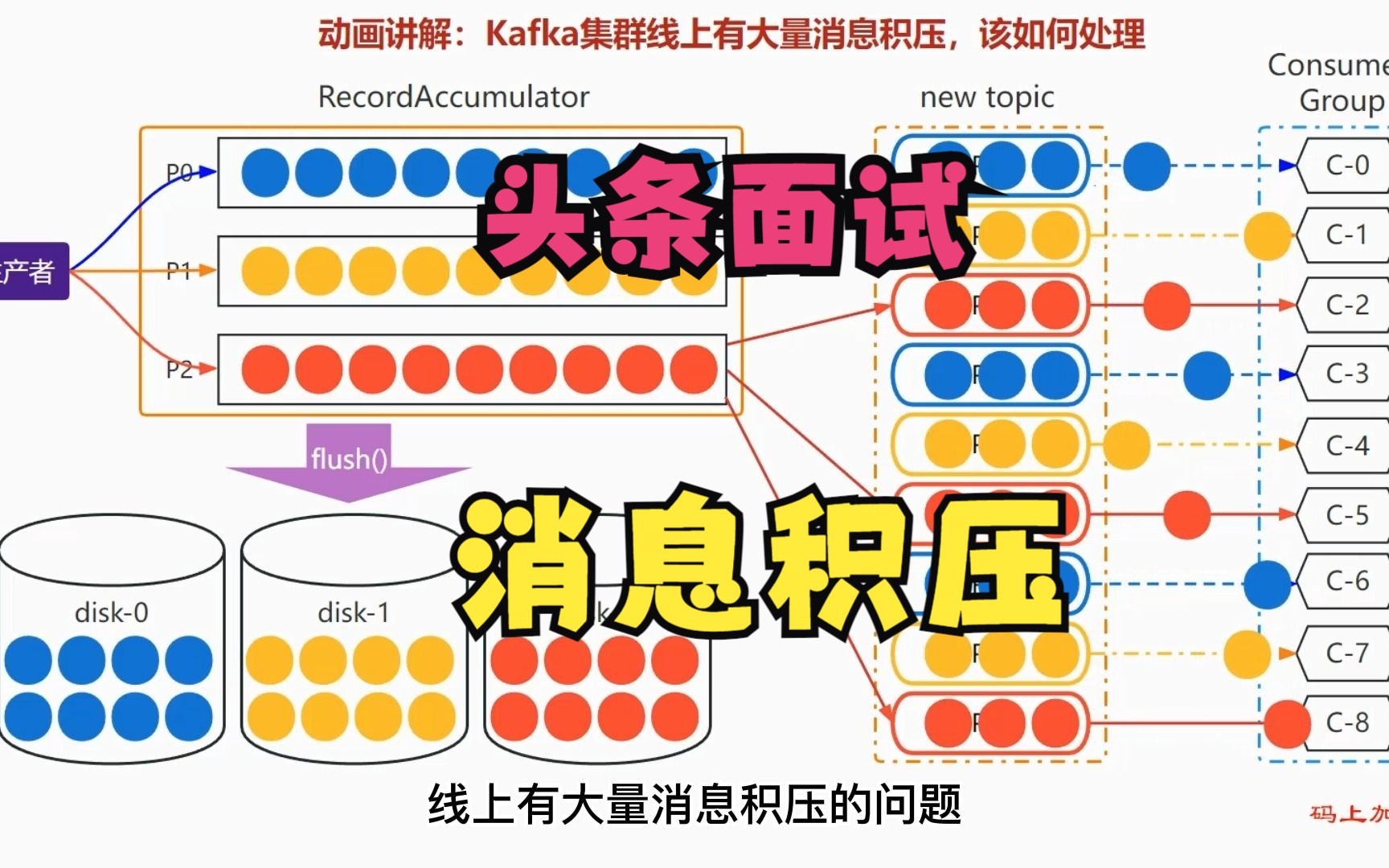

kafka消息积压解决方法2中提到,把积压的消息放入新的topic,新topic的partition数量设置多一些,然后consumer从新topic中去消费。这里consumer数量跟partition数量一致,也是增多了,请问如何增加consumer的数量呢?我理解也是增加了硬件资源。 DomiZhang:

DomiZhang:

老师,RecordAccumulator不是Producer的组件吗?为啥图里ConsumerGroup没有经过Broker直接就读RecordAccumulator了呢 tanne222:

tanne222:

可以再往后延展下,比如新topic的数据,谁负责写进去?同步这块数据的时候,怎么保证数据不丢失呢?Up主这个做的很良心,光是这个动图,就赢了95%。有图有真相,在计算机行业里太重要了 ZARuAaa:

ZARuAaa:

增加物理节点,让工程师写出更多新的bug让大家去解决[doge] 孙子小23333:

孙子小23333:

怎么把旧kafka分区的数据写入到新kafka扩容topic分区里面,是直接执行什么命令吗

【回复】来自chatGPT的答案:

在将旧 Kafka 分区的数据写入到新 Kafka 扩容 topic 分区的过程中,可以通过编写程序来实现。下面是一些编写程序的例子:

使用 Kafka 提供的工具 kafka-reassign-partitions.sh 进行数据迁移【2】。这个工具可以自动为你创建新的扩容主题并将旧主题的数据迁移到新主题中。可以通过生成迁移计划和执行迁移命令来完成这个过程。

使用 Kafka 的 Java API 进行数据迁移。Kafka 提供了一套完整的 Java API,可以使用这个 API 实现从旧主题到新主题的数据迁移。可以编写一个 Java 程序来实现这个过程,具体可以参考 Kafka 的官方文档【1】。

在编写程序时,需要注意以下几点:

在进行数据迁移时,需要确保旧主题和新主题的数据格式和编码方式相同,否则会导致数据无法被正确读取。

在进行数据迁移时,需要确保新主题的分区数量足够大,否则可能会出现数据倾斜的问题。

在进行数据迁移时,需要确保 Kafka 集群的性能和稳定性,避免在迁移过程中出现数据丢失或者数据损坏等问题。

总之,编写程序进行数据迁移是一个比较复杂的过程,需要仔细考虑,充分测试和验证,确保数据迁移过程安全、高效、可靠。

【回复】最好是写个程序来处理,命令行不好控制