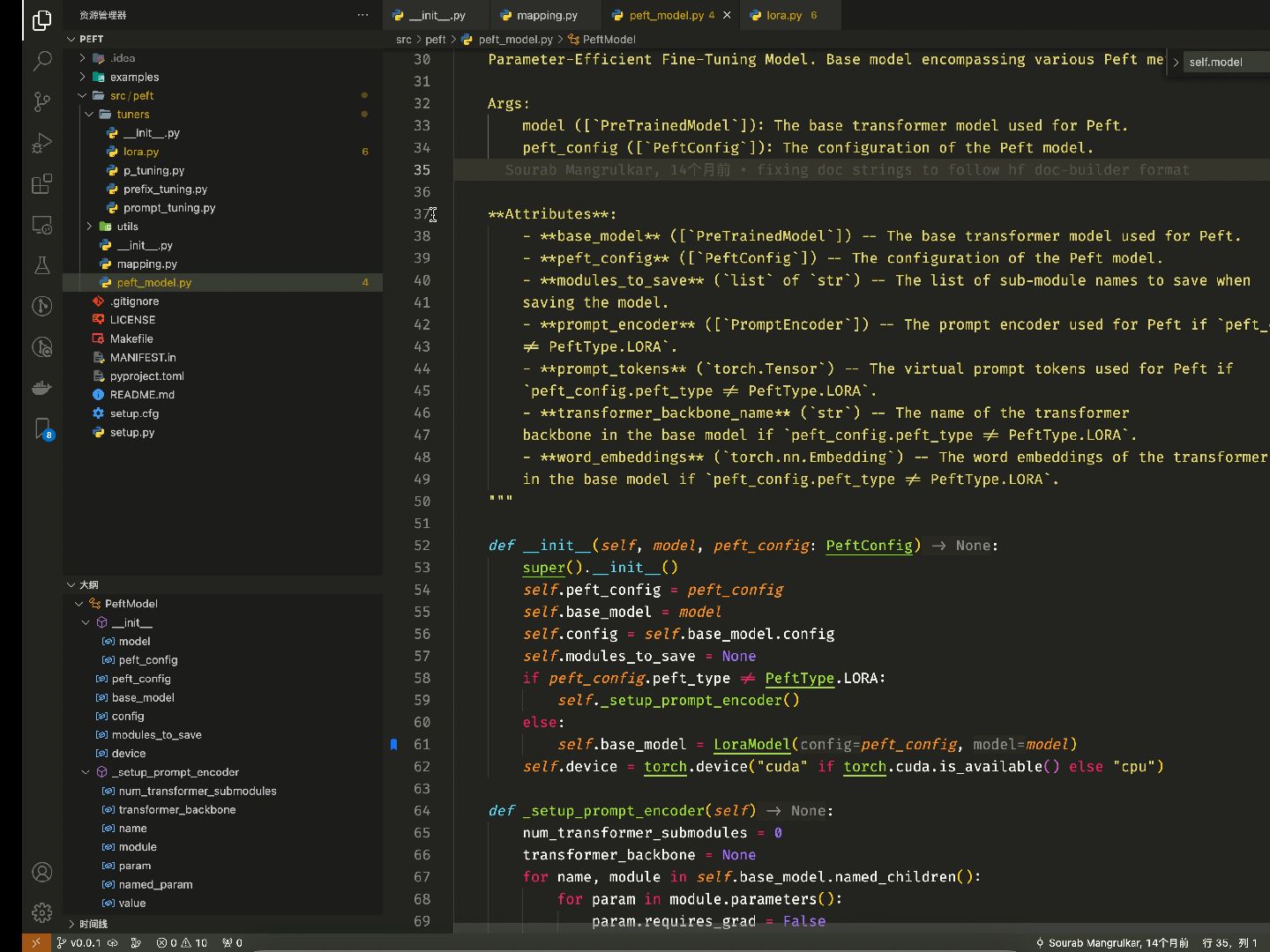

lora源码解读

如何成为jyy的学生:

如何成为jyy的学生:

佬,huggingface的trainer可以直接直接训练tokenize后的数据吗?

【回复】回复 @良睦路程序员 :佬发个视频吗?如果有现成的代码也可以贴个链接

【回复】当然可以哇,兄弟[呲牙] newlinfeng:

newlinfeng:

佬,可以基于cl100k词库做一个提高中文压缩比的tokenizer吗?

【回复】这个现在没必要做了奥,压缩词表好像没啥用了[笑哭],想看的话,可以做 Qlora微调低精度大模型:

Qlora微调低精度大模型:

良老板把视频拆成1分钟的视频,4个视频,就可以有8个硬币[滑稽]

【回复】还不是为了多骗一点你们的硬币(主要还是希望视频短一点,你们看着舒服一点,呜呜呜) 你来我往谁为先手:

你来我往谁为先手:

up主你好,可以讲一下gemma吗?像讲llama似的。我要在gemma-2B上做量化,但是发现transformer库默认是7B,就不知所措了

【回复】emmm,后面安排一下最简单的教程~ 炳yan:

炳yan:

想问一下,用peft库是不是仅仅能用那4种业务方式,seq_cls,token_cls,causal_lm,seq2seqlm

【回复】嗯嗯 谢谢回答,还想请问一下,还有其他接口吗,我用get_peft_model并传入loraconfig好像行不通。我想微调一个文本编码器,输入两个文本,输出余弦距离,好像这几种都不行

【回复】不是的,使用别的任务也是可以的

大模型 nlp LoRa 源码解读